用户

ID: 剩余积分:

积分仅限于AI文章写作也可以用于Wordpress下的SEO合集插件“智能改写”“词库挖掘”“关键词排名监控”“AI智能DK”功能使用;

充值仅用于消费,不可变更,退款,提现,请慎重选择!

用户邮箱

验证码

暂无数据

robots.txt是一种文本文件,用于告知搜索引擎蜘蛛(也称为网络爬虫)哪些页面可以被抓取和索引,哪些页面不应该被抓取和索引。它是网站所有者用来控制搜索引擎爬取行为的一种方式。

通过在网站根目录下创建并维护robots.txt文件,网站管理员可以指示搜索引擎爬虫访问或禁止访问特定页面或目录。robots.txt文件中可以包含一系列规则,指定允许或禁止搜索引擎爬虫访问的URL路径。

使用robots.txt文件的主要目的是:

控制搜索引擎爬虫:网站所有者可以使用robots.txt文件来指示搜索引擎蜘蛛哪些页面可以被抓取和索引,哪些页面不应该被抓取和索引。这有助于控制搜索引擎爬虫的行为,避免抓取敏感信息、重复内容或其他不想被索引的页面。

保护隐私和安全:通过禁止搜索引擎爬虫访问敏感页面或目录,可以提高网站的隐私和安全性。例如,禁止搜索引擎爬虫访问登录页面、个人信息页面或其他需要保护的页面。

节省带宽和资源:通过限制搜索引擎爬虫的抓取范围,可以减少对服务器带宽和资源的消耗。这对于大型网站或有限资源的服务器来说尤为重要。

需要注意的是,robots.txt文件只是给搜索引擎爬虫提供了一些建议,而不是强制规定。一些不端的爬虫可能会忽略robots.txt文件的指示,所以敏感信息或重要页面的保护还需要其他的安全措施。

如何判断别人的网站有没有配置robtos.txt呢?直接访问他网站后面添加分目录即可,例如:https://www.rbzzz.com/robots.txt

要配置robots.txt文件,您需要按照以下步骤进行操作:

创建一个文本文件:在您的网站根目录下创建一个名为"robots.txt"的文本文件。确保将文件命名为"robots.txt",并确保它位于网站的根目录中。

编写规则:在robots.txt文件中,您可以编写一系列规则来指示搜索引擎爬虫的行为。每个规则由两个主要部分组成:User-agent和Disallow。

下面是一个示例robots.txt文件的示例:

User-agent: * Disallow: /private/ Disallow: /admin/

在上面的示例中,"*"表示适用于所有爬虫。Disallow指令指示不允许访问"/private/"和"/admin/"目录。

User-agent:指定适用于该规则的搜索引擎爬虫。例如,"*"表示适用于所有爬虫,"Googlebot"表示适用于Google爬虫。

Disallow:指定不允许搜索引擎爬虫访问的URL路径。您可以使用斜杠(/)指定根目录,或者使用特定的URL路径。

保存文件:将编辑好的robots.txt文件保存在网站的根目录中。

验证文件:验证您的robots.txt文件是否正确配置。您可以使用Google的"robots.txt测试工具"或其他类似的工具来验证文件的语法和规则是否正确。

上传文件:将编辑好的robots.txt文件上传到您的网站的根目录中。

请注意,配置robots.txt文件只是给搜索引擎爬虫提供了一些建议,而不是强制规定。一些不端的爬虫可能会忽略robots.txt文件的指示,所以敏感信息或重要页面的保护还需要其他的安全措施。

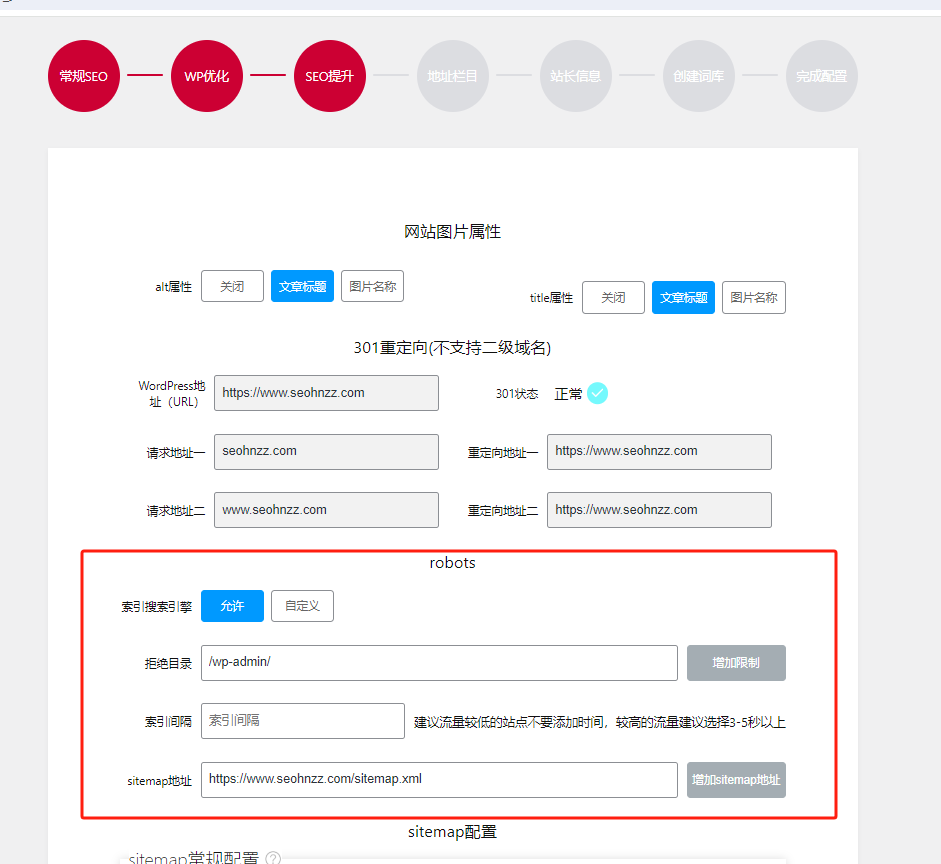

wordpress网站用户,可以直接安装SEO合集插件,在引导模式下直接可视化配置生成即可。